Kafka vs. Kinesis: Welche Lösung passt für mich? Ein Vergleich am Beispiel von Sensordaten.

Wer sich mit der Verarbeitung großer Datenströme beschäftigt, stößt früher oder später auf den Vergleich zwischen Apache Kafka und AWS Kinesis. Doch welches System ist das Richtige für welchen Anwendungsfall? Zur Aufklärung dieser Frage soll der folgende Artikel beitragen.

In aller Kürze

Dieser Artikel vergleicht die beiden Streaming-Dienste Apache Kafka und AWS Kinesis hinsichtlich Architektur, Skalierbarkeit, Verwaltung und typischer Anwendungsfälle wie der Verarbeitung von Sensordaten. Beide Systeme ermöglichen die zuverlässige Echtzeitübertragung großer Datenmengen, unterscheiden sich jedoch in ihrer Bedienung und dem Grad der Kontrolle. Kafka bietet als Open-Source-Lösung hohe Flexibilität und ist Cloud unabhängig, erfordert jedoch tieferes technisches Know-how im Eigenbetrieb. Kinesis hingegen punktet mit einfacher Handhabung und nahtloser AWS-Integration, eignet sich aber primär für AWS-zentrierte Infrastrukturen. Mit AWS MSK steht zudem eine hybride Lösung zur Verfügung, die Kafka als Managed Service in AWS-Umgebungen einbettet und einen Mittelweg zwischen Eigenbetrieb und Komplettverwaltung bietet.

Anwendungsfall: Sensordaten

Ein klassisches Beispiel ist die Verarbeitung von Sensordaten mit hohem Datenauf-kommen. Wer etwa Temperaturen misst, braucht aktuelle Werte – nicht die von vor 20 Minuten und möchte auch nicht 20 Minuten auf die nächste Aktualisierung warten. Ein Sensor, der nur alle 20 Minuten Daten liefert, wäre ungeeignet für einen Ofen, der sich bei Erreichen einer Zieltemperatur abschalten soll – sonst ist der Kuchen schnell ruiniert. Weiterhin sind in vielen Anwendungsfällen historische Daten zweitrangig. Wobei immer die Möglichkeit besteht, die Werte an einen dauerhaften Speicher weiterzuleiten. Es sind aber auch viele weitere Anwendungsfälle denkbar, wie zum Beispiel Echtzeitdashboards oder die Auswertung von Logdaten.

Beide Tools erfüllen grundlegend die gleiche Aufgabe, aber unterscheiden sich im Detail. Im folgenden Artikel wird die Funktionsweise beider beleuchtet und kläret, welche Technologie in welcher Situation geeignet ist. Dabei soll auch betrachtet werden wie AWS MSK und Kafka verbunden sind und warum für eine Open Source Lösung mit Kafka unter Umständen MSK eine gute Ergänzung der Architektur sein kann.

Aufgabe

Für beide Dienste ist der Einsatzbereich die Echtzeitdatenübertragung (Streaming). Beide Systeme sind darauf ausgelegt, große Datenmengen in Echtzeit zu verarbeiten. Mittels Partitionierung wird Skalierung ermöglicht. Für hohe Last können schnell neue Partitionen aufgenommen werden. Die Systeme lassen sich durch zusätzliche Partitionen oder Shards bei hoher Last skalieren. Eine Reduzierung ist ebenfalls möglich, erfordert jedoch Planung und Anpassung. Dabei können Daten von verschiedenen Quellen an verschiedene Ziele weitergeleitet werden. Die Daten bleiben für einen definierten Zeitraum gespeichert, sodass Empfänger diese in eigener Geschwindigkeit abnehmen können.

Damit verbunden ist häufig die Nutzung zur Entkoppelung von Datenannahme und Datenverarbeitung. Wenn Daten im verarbeitenden System auch direkt angenommen werden, können Verarbeitungsprobleme zu Verzögerung und Verlust von Daten bei der Annahme führen. Ein Temperatursensor liefert in der Regel nur aktuelle Werte, wobei verpasste Daten nicht erneut gesendet werden. Was von einem Folgesystem nicht verarbeitet und gespeichert wird, ist in der Regel unwiederbringlich verloren.

Vergleich Kafka vs. Kinesis

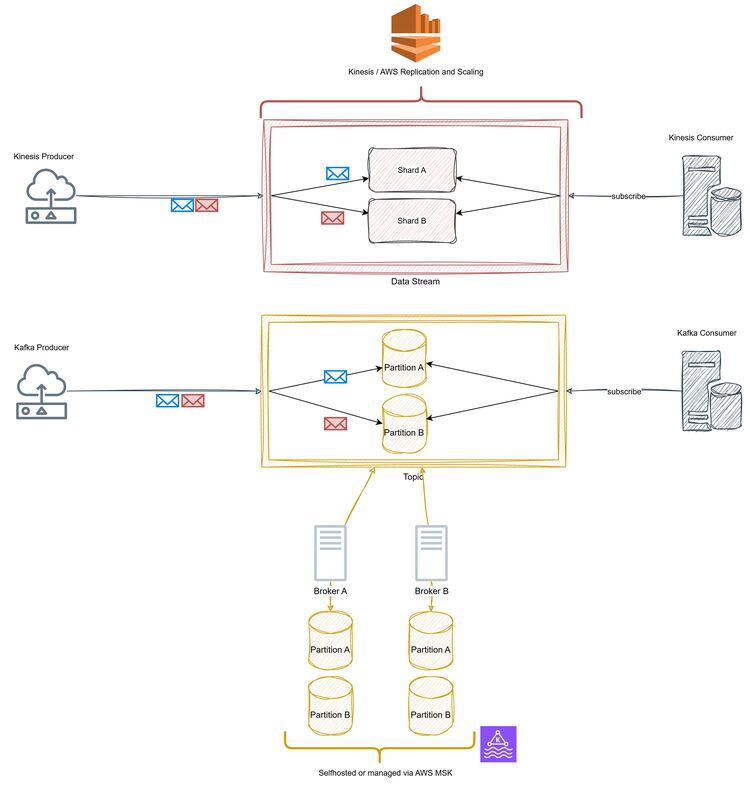

Architektur im Überblick

Kafka ist ein Open-Source-System mit Topics, Partitionen und Brokern zur Verwaltung und Replikation.

Kinesis ist ein vollständig verwalteter AWS-Service, der mit Streams und Shards arbeitet.

Gemeinsamkeiten beider Systeme:

- Datenfluss: Producer → Stream → Consumer

- Horizontale Skalierung über Partitionen (Kafka) bzw. Shards (Kinesis)

- Temporäre Speicherung ermöglicht eine entkoppelte Datenverarbeitung

Kinesis

Kinesis ist ein vollständig verwalteter Streaming-Service von AWS. Infrastruktur, Skalierung und Verfügbarkeit übernimmt AWS, womit eigener Aufwand entfällt. Da Kinesis tief in die AWS-Umgebung integriert ist, eignet es sich besonders für Nutzer, die schnell starten und wenig Verwaltungsaufwand haben möchten.

Kernkomponenten:

- Producer

- Consumer

- Stream

- Shard

Kafka

Kafka ist ein Open-Source-Projekt der Apache Software Foundation. Es kann selbst betrieben oder über Dienste wie AWS MSK genutzt werden. Im Eigenbe-trieb sind fundierte Kenntnisse erforderlich, insbesondere für Skalierung, Überwachung und Sicherheit. Wer weniger Aufwand betreiben möchte, kann auf Managed-Services wie MSK zurückgreifen.

Kernkomponenten:

- Producer

- Consumer

- Topic

- Partition

- Broker

MSK als Brücke zwischen Eigenbetrieb und Managed Service

Wer Kafka nicht selbst betreiben möchte, kann auf einen Managed Service wie AWS MSK (Managed Streaming for Kafka) zurückgreifen. MSK übernimmt viele Aufgaben wie das Infrastrukturmanagement, die automatische Skalierung und Sicherheitsfeatures wie die Integration mit AWS IAM. Dadurch lässt sich Kafka wesentlich einfacher in AWS-Projekte integrieren.

Der Betriebsaufwand sinkt dadurch deutlich und liegt in etwa auf dem Niveau von Kinesis. Der Eigenbetrieb von Kafka ist zwar auch möglich, erfordert aber tiefes Know-how und einen hohen Administrationsaufwand - insbesondere bei Themen wie Skalierung, Ausfallsicherheit und Sicherheit.

Die Bestandteile

Kinesis und Kafka funktionieren im Grunde ganz ähnlich. Beide setzen auf eine zentrale Datenablage – bei Kinesis heißt sie „Data Stream“, bei Kafka „Topic“. Zur besseren Skalierbarkeit wird der Speicher in kleinere Einheiten aufgeteilt: Kinesis nennt diese Einheiten „Shards“, bei Kafka heißen sie „Partitionen“.

Kafka hat außerdem noch sogenannte „Broker“. Diese Server speichern die Daten redundant, um Ausfallsicherheit zu gewährleisten. Bei Kinesis gibt’s dafür kein direktes Pendant, denn AWS kümmert sich automatisch um Verfügbarkeit und Replikation im Hintergrund.

Das Grundprinzip bleibt aber bei beiden gleich: Über eine API kann man eigene Producer (die Daten liefern) und Consumer (die Daten abholen) programmieren. Dabei helfen verschiedene fertige Bibliotheken. Die Übertragung zwischen Producer und Consumer übernimmt das jeweilige System automatisch.

Fazit

Beide Systeme erfüllen den gleichen Zweck: die zuverlässige und skalierbare Übertragung großer Datenmengen in Echtzeit. Kafka punktet mit Flexibilität und einem starken Open-Source-Ökosystem. Kinesis überzeugt durch einfache Bedienung und tiefgreifende Integration in AWS. Die Wahl hängt davon ab, ob man maximale Kontrolle oder minimale Verwaltung bevorzugt. Zusätzlich ist ausschlaggebend, ob ein System Cloud Übergreifen arbeiten soll. Hier ist Kafka eine gute Wahl. Wir spezifisch auf AWS gesetzt kann hingegen die relative Einfachheit von Kinesis voll ausgeschöpft werden.

Quellen

[1] https://kafka.apache.org/intro

[2] https://aws.amazon.com/de/kinesis/data-streams/faqs/

[3] https://medium.com/swlh/apache-kafka-what-is-and-how-it-works-e176ab31fcd5

[4] https://docs.aws.amazon.com/msk/latest/developerguide/what-is-msk.html

[5] https://kafka.apache.org/documentation/

[6] https://youtu.be/UbNoL5tJEjc?feature=shared

[7] https://youtu.be/B5j3uNBH8X4?feature=shared

[8] https://docs.aws.amazon.com/msk/latest/developerguide/msk-cluster-management.html